Music and acoustic Engineering:

mercoledì lauree per 22 studenti

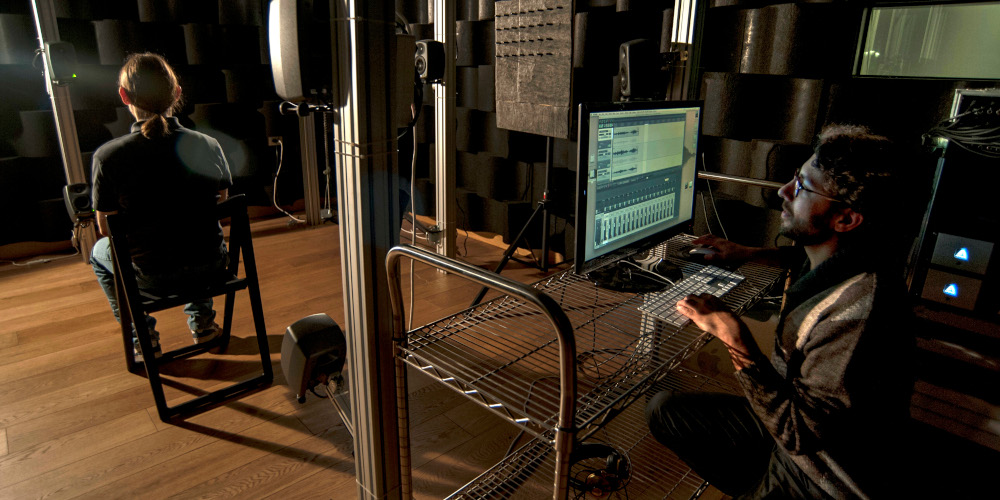

Mercoledì 27 aprile altra sessione di laurea nel Campus di Cremona del Politecnico di Milano. Saranno ben ventidue gli studenti, che completeranno il loro percorso con la discussione di laurea e raggiungeranno un ambito traguardo: la Laurea Magistrale in Music and Acoustic Engineering, prima ed unica in Italia interamente dedicata all’ingegneria della musica e dell’acustica.

Dei laureandi di questa sessione, quindici hanno scelto di approfondire la loro preparazione in tema di informatica musicale ed elaborazione del suono, mentre sette si sono concentrati sull’acustica.

Nata nella Città di Stradivari grazie al sostegno del territorio, in particolare della Fondazione Arvedi Buschini e del Comune di Cremona, questa nuova Laurea Magistrale è attrattiva non solo per gli universitari italiani ma anche per i laureati internazionali provenienti da diversi Paesi Extra Ue, con una formazione sia ingegneristica che musicale.

Il Campus di Cremona può vantare infatti un percorso estremamente innovativo che prevede la collaborazione con la Facoltà di Musicologia dell’Università degli Studi di Pavia e del Conservatorio di Milano e la presenza di un Laboratorio di Acustica Musicale, dotato di una camera anecoica, dedicato allo sviluppo di tecnologie avanzate per il miglioramento della tradizione liutaria e di metodologie sistematiche per la valutazione quantitativa delle caratteristiche fisiche e acustiche degli strumenti di liuteria. Due sono gli orientamenti tra cui gli interessati possono scegliere: Acoustic Engineering per chi vuole approfondire il tema dell’acustica musicale e Music Engineering per chi invece vuole focalizzarsi sullo studio dell’informatica musicale e l’elaborazione del suono.

Per chi vuole conoscere meglio questo innovativo Corso di Laurea Magistrale il Polo di Cremona ha organizzato per il 4 maggio un Open Day durante il quale sarà possibile partecipare alla presentazione del corso, all’illustrazione dei progetti di tesi con una testimonianza dei laureati e sarà possibile effettuare colloqui con docenti.

Iscrizioni entro domenica 1 maggio. Per maggiori informazioni è possibile consultare il sito: www.polo-cremona.polimi.it

L’ELENCO DEI LAUREANDI

ATTORRESI LUIGI

Titolo tesi: Combining Automatic Speaker Verification and Prosody Analysis for Synthetic Speech Detection

Abstract

I recenti sviluppi dell’intelligenza artificiale hanno portato a incredibili innovazioni che stanno rapidamente prendendo parte alla nostra vita quotidiana. È questo il caso dei deepfake, una nuova pratica che permette di generare dei contenuti multimediali iperrealistici, ma falsi. È possibile, ad esempio, sostituire il viso di una persona con quello di un’altra in una foto o in un video, oppure imitare la voce di qualcuno facendogli dire ciò che si vuole. Tuttavia, molto spesso a importanti innovazioni corrispondono anche grandi minacce. Infatti, tale tecnologia può essere molto pericolosa quando la si sfrutta con lo scopo di rubare l’identità della vittima, screditarla o diffondere notizie false. Un video che ritrae un personaggio pubblico con un forte impatto sociale in un discorso mai pronunciato potrebbe avere conseguenze tremende. La stessa cosa accadrebbe per del materiale pornografico che, con un semplice scambio di volti, ritrae una celebrità di fama mondiale. Infine, una voce clonata potrebbe prestarsi a frodi telefoniche o contraffazioni di prove giudiziarie. Purtroppo, questa non è una descrizione distopica di un futuro prossimo, ma si tratta di fatti realmente accaduti. È cruciale quindi avere a disposizione dei mezzi per contrastare tali contraffazioni. Questa tesi propone un sistema in grado di riconoscere se un dato audio contenga del parlato sintetico, oppure autentico. Il nostro approccio parte dall’ipotesi che le tecniche di contraffazione non siano ancora in grado di ricreare in modo realistico gli aspetti semantici più complessi della voce. Per questo motivo ci serviamo di una rappresentazione del parlato che tenga conto di due caratteristiche di alto livello: l’identità vocale, legata al timbro e all’intonazione, e la prosodia, che consideriamo un aspetto molto sottile, ma distintivo della voce, legato a caratteristiche comportamentali e abitudini nel parlare, come stile, accento o tono. Valutiamo il nostro sistema sotto diversi aspetti mediante una serie di esperimenti ad-hoc che coinvolgono una grande quantità di audio reali e deepfake. In questo modo dimostriamo l’efficacia e l’innovazione del nostro metodo rispetto a quelli già esistenti. Inoltre, analizziamo la sua capacità di generalizzare in contesti meno controllati e la robustezza a manipolazioni aggiuntive, come ad esempio la compressione, tipicamente applicata ai deepfake per nascondere le tracce di contraffazione. I risultati di queste analisi sono eccellenti e aprono a possibili scenari futuri e miglioramenti del modello.

BADIANE DAVID GIUSEPPE

Titolo tesi: From the Frequency Response of Wooden Plates to their Material Parameters

Abstract

La caratterizzazione del legno con metodi non distruttivi è un argomento importante nell’acustica musicale. Infatti, da un lato la performance acustica degli strumenti a corda è influenzata dalle proprietà elastiche del loro materiale. Dall’altro lato, il legno utilizzato per costruire la loro tavola armonica (i.e. di solito, piatti di abete o di cedro) mostrano proprietà elastiche altamente variabili. Quindi, il primo passo per la costruzione di uno strumento è la scelta del legno. Tecniche di Controllo Non Distruttivo (CND) per una caratterizzazione del legno veloce e accurata aiuterebbero i liutai sia nella selezione del legno che nel futuro design dello strumento. Una classe popolare di tecniche CND sono i metodi di Finite Element Model Updating (FEMU). Generalmente, questi metodi coinvolgono una campagna di misure sperimentali sul corpo studiato e un modello a elementi finiti della sua vibrazione. Le proprietà del materiale vengono identificate minimizzando la differenza tra la quantità misurata e la sua controparte calcolata numericamente. Tuttavia, queste tecniche non sono appropriate ad essere utilizzate dai liutai, in quanto sono costose in termini di tempo e tecnicamente complesse. Per risolvere questi problemi, in questa tesi presentiamo una nuova ed efficiente metodologia, denominata FRF2Params, basata su reti neurali per caratterizzare piatti di legno. La tecnica consente di stimare simultaneamente i parametri meccanici a partire da una singola Funzione di Risposta in Frequenza (FRF) valutata per punti di misura prestabiliti. La FRF si può ottenere con un sistema di misura non distruttivo, basato su un piccolo martello e un accelerometro. Le reti neurali sono addestrate tramite un dataset sintetico (i.e. ottenuto con simulazioni numeriche) contenente i dati vibrazionali di piatti di dimensione e proprietà elastiche variabili. I nostri risultati dimostrano che FRF2Params è in grado di stimare le proprietà del legno in modo accurato e veloce. Questo lavoro apre la strada allo sviluppo di uno strumento basato su reti neurali che possa aiutare i liutai durante la costruzione dei loro strumenti.

BOSI SAMUELE

Titolo tesi: Audio-Video techniques for the analysis of players behaviour in Badminton matches

Abstract

L’analisi del comportamento dei giocatori e lo studio delle statistiche ad esso correlate è da sempre un punto cardine nello sport professionistico. Gli atleti durante gli allenamenti vengono costantemente monitorati con l’obiettivo di migliorare le performance attraverso sessioni e strategie create ad-hoc. Gli allenatori registrano continuamente partite in modo da poterle analizzare con maggior attenzione, allo scopo di estrarre statistiche utili a tracciare un completo profilo sia dei propri giocatori che dei giocatori avversari. Sfortunatamente, però, l’estrazione della gran parte di queste utili statistiche è ancora svolta da esperti del settore che annotano manualmente video e registrazioni. Grazie all’avanzamento nel campo della computer vision e del deep learning, oggigiorno è possibile dare un supporto all’annotazione manuale introducendo delle tecniche automatiche o semi-automatiche di analisi multimediale. In questo elaborato, viene proposta una soluzione per l’analisi audio e video del comportamento di giocatori di Badminton. Ponendo sotto esame un video di una partita di Badminton, vengono qui proposte una serie di tecniche che consentono: (i) l’individuazione attiva delle sezioni di interesse del video, utilizzando metodi comparativi tra frames; (ii) l’individuazione e il tracciamento della posizione dei giocatori sul campo, mediante una Convolutional Neural Network (CNN) adattata ai nostri fini; (iii) l’individuazione e il tracciamento della posizione del volano nei frame, sfruttando una appositamente sviluppata CNN, e ; (iv) il rilevamento dei colpi al volano inferti da entrambi i giocatori, attraverso l’utilizzo di un innovativo metodo di analisi audiovisiva. I risultati ottenuti su una serie di video pre-annotati mostra le performance ottenute da ogni componente del sistema, le preliminari applicazioni a cui può portare quest’analisi e mette in mostra le criticità del problema per gli studi futuri.

BOTTI TOMMASO

Titolo tesi: Active Structural-Acoustic Control on interior noise of a plate-cavity system using FxNLMS algorithm

Abstract

Recentemente, una crescente attenzione viene posta al tema del rumore ambientale in seguito all’impatto negativo che quest’ultimo ha sulla salute fisica e mentale delle persone. Una delle soluzioni di mitigazione del rumore più promettenti è l’applicazione di strutture intelligenti, la cui performance acustica è attivamente controllata. Nel lavoro presentato, un Controllo Acustico-Strutturale Attivo (ASAC) viene sviluppato su un sistema pannello-cavità, con l’obiettivo di ridurre il rumore in alcune posizioni della stessa. L’algoritmo utilizzato è il Filtered-x Normalized Least Mean Squares (FxNLMS), tipico di problemi di Cancellazione Attiva del Rumore (ANC), ma con la peculiarità che il controllo viene direttamente applicato alla vibrazione del pannello, come avviene in strategie di Controllo Attivo della Vibrazione (AVC). L’algoritmo è stato implementato in configurazione Single Input Single Output (SISO) e Single Reference Multiple Error (SRME), dove quest’ultima rappresenta un primo passo verso un’architettura multicanale. Il sistema pannello cavità è costituito da un pannello di vetro a singolo strato e da una struttura in cemento armato chiamata Noise Box, progettata per riprodurre il campo sonoro interno all’abitacolo di un veicolo. Il pannello è stato dotato di trasduttori piezoelettrici utilizzati come attuatori, mentre come sensori sono stati utilizzati microfoni a condensatore. Inizialmente è stata realizzata una Modellazione ad Elementi Finiti (FEM) seguita da una campagna di simulazioni, sia nel dominio del tempo che in quello delle frequenze, per caratterizzare il comportamento del sistema e per estrarre alcune Funzioni di Risposta in Frequenza (FRFs) necessarie al funzionamento dell’algoritmo. In seguito, una ricostruzione modale delle FRFs è stata attuata per sviluppare un modello ridotto del sistema, sfruttando la sua linearità, riducendo in questo modo il costo computazionale di simulazioni nel dominio del tempo e rendendo possibile una prima calibrazione dell’architettura di controllo. Infine, sono state svolte attività sperimentali che hanno permesso di dimostrare l’efficacia della logica di controllo sviluppata sia per la configurazione SISO che per quella SRME, mostrando la capacità della struttura intelligente di raggiungere un quasi totale abbattimento del rumore nelle posizioni della cavità designate.

BOTTI NICOLO’

Titolo tesi: Active Structural-Acoustic Control on interior noise of a plate-cavity system using FxNLMS algorithm

Abstract

Recentemente, una crescente attenzione viene posta al tema del rumore ambientale in seguito all’impatto negativo che quest’ultimo ha sulla salute fisica e mentale delle persone. Una delle soluzioni di mitigazione del rumore più promettenti è l’applicazione di strutture intelligenti, la cui performance acustica è attivamente controllata. Nel lavoro presentato, un Controllo Acustico-Strutturale Attivo (ASAC) viene sviluppato su un sistema pannello-cavità, con l’obiettivo di ridurre il rumore in alcune posizioni della stessa. L’algoritmo utilizzato è il Filtered-x Normalized Least Mean Squares (FxNLMS), tipico di problemi di Cancellazione Attiva del Rumore (ANC), ma con la peculiarità che il controllo viene direttamente applicato alla vibrazione del pannello, come avviene in strategie di Controllo Attivo della Vibrazione (AVC). L’algoritmo è stato implementato in configurazione Single Input Single Output (SISO) e Single Reference Multiple Error (SRME), dove quest’ultima rappresenta un primo passo verso un’architettura multicanale. Il sistema pannello cavità è costituito da un pannello di vetro a singolo strato e da una struttura in cemento armato chiamata Noise Box, progettata per riprodurre il campo sonoro interno all’abitacolo di un veicolo. Il pannello è stato dotato di trasduttori piezoelettrici utilizzati come attuatori, mentre come sensori sono stati utilizzati microfoni a condensatore. Inizialmente è stata realizzata una Modellazione ad Elementi Finiti (FEM) seguita da una campagna di simulazioni, sia nel dominio del tempo che in quello delle frequenze, per caratterizzare il comportamento del sistema e per estrarre alcune Funzioni di Risposta in Frequenza (FRFs) necessarie al funzionamento dell’algoritmo. In seguito, una ricostruzione modale delle FRFs è stata attuata per sviluppare un modello ridotto del sistema, sfruttando la sua linearità, riducendo in questo modo il costo computazionale di simulazioni nel dominio del tempo e rendendo possibile una prima calibrazione dell’architettura di controllo. Infine, sono state svolte attività sperimentali che hanno permesso di dimostrare l’efficacia della logica di controllo sviluppata sia per la configurazione SISO che per quella SRME, mostrando la capacità della struttura intelligente di raggiungere un quasi totale abbattimento del rumore nelle posizioni della cavità designate.

CANTONI CORRADO

Titolo tesi: Development of an Artistic Installation on World Happiness exploiting Deep Learning techniques for Conditioned Visual Experience Generation

Abstract

La felicità è una esperienza umana soggettiva e il termine “felicità” è allo stesso tempo una parola di complessa interpretazione. Tuttavia, studi dimostrano una forte correlazione tra la popolazione proveniente da una specifica area geografica e alcuni parametri di tipo socioeconomico. Secondo il World Happiness Report (WHR), specifici indicatori vengono utilizzati oggi per una interpretazione oggettiva del benessere personale, economico, sociale della popolazione residente in uno specifico paese. L’indicatore denominato “Life Ladder (LL)”, il parametro numerico che si riferisce al benessere, è inserito tra gli indicatori che definiscono il progresso generale di un paese. Questa tesi propone per la prima volta lo sviluppo di una installazione artistica basata sull’utilizzo di tecniche innovative di Deep Learning allenate sui dati del World Happiness report per la generazione di esperienza visive che esprimano il livello di felicità identificato da un insieme di indicatori definiti dall’utente. Utilizziamo la Regressione come metodo per configurare un ambiente allenato sugli undici indicatori di felicità proposti dal WHR. Il sistema è abile a generare il LL da altri indicatori inseriti dall’utente che interagisce col sistema, in linea con i livelli di benessere sperimentalmente rilevati in tutto il mondo. Utilizziamo il LL predetto come input per una Instance Conditioned Generative Adversarial Network (IC-GAN) per generare immagini e conduciamo l’interazione essere umano – macchina attraverso l’utilizzo di immagini personalizzate dall’utente come istanza condizionante la generazione. Infine, utilizziamo una Enhanced Super Resolution Generative Adversarial Network (ESRGAN) come tecnica per fornire un incremento della risoluzione e dettaglio all’immagine generata e aggiungere texture e profondità riferibili a un’immagine disegnata da una mano esperta. Attraverso un test percettivo analizziamo la correlazione positiva trovata tra il dato individuale calcolato e la sua rappresentazione tramite l’immagine successivamente generata.

CASTELLI FRANCESCO

Titolo tesi: A metric learning approach for splicing localization based on synthetic speech detection

Abstract

Con il rapido progresso delle tecniche di intelligenza artificiale degli ultimi anni, la possibilità di generare video, immagini e audio estremamente realistici è alla portata di tutti. Queste tecnologie hanno aperto la strada alla creazione di deepfakes, contenuti multimediali prodotti utilizzando tecniche di deep learning che rappresentano realisticamente persone in comportamenti ingannevoli. Anche se principalmente utilizzati per puro intrattenimento, è da subito apparso evidente che il loro impiego potesse causare problemi e danni alle persone rappresentate. Infatti, al giorno d’oggi non è difficile trovare online casi di diffusione di fake news, frodi e bufale che coinvolgono i deepfake. In questo contesto, la componente audio gioca un ruolo importante, poiché la maggior parte dei deepfake si presenta sotto forma di video in cui l’audio riveste un ruolo di assoluta importanza per il realismo del risultato finale. Inoltre, sta diventando sempre più comune l’uso di deepfake composti da solo audio. Questo sviluppo viene sostenuto anche dalla continua evoluzione dei sistemi di sintesi vocale, che sono ormai in grado di generare audio altamente realistici con pochissimi secondi di parlato della persona che si vuole imitare. È quindi evidente l’importanza di un metodo automatico per la rilevazione di questi falsi. Tuttavia, un ulteriore minaccia è costituita dalla combinazione di audio splicing, una tecnica utilizzata per sostituire solo parti di un audio con l’obbiettivo di cambiarne l’intero significato, e deepfake. In questa tesi consideriamo il problema del rilevamento e della localizzazione dello splicing basato sulla produzione sintetica della voce. Siamo interessati solo ad audio creati sostituendo parti del segnale originale con porzioni di audio generate sinteticamente. Se usata per scopi malevoli, questa tecnica può produrre tracce incredibilmente realistiche che possono facilmente ingannare i migliori rilevatori automatici, poiché l’audio contiene ancora sezioni del parlato originale. Affrontiamo il problema dividendo il segnale sospetto in sezioni, anche sovrapposte, che vengono poi mappate in uno spazio di embeddings grazie all’utilizzo di reti neurali allenate per distinguere audio reali da parlato falso. Andiamo poi a calcolare la funzione di novelty partendo dagli embeddings estratti. Questa ci consente di analizzare la somiglianza tra i vari embeddings. Quando la funzione di novelty mostra picchi con prominenza significativa, viene rilevato e localizzato un punto di splicing all’interno dell’audio. In particolare, sfruttiamo l’importanza del metric learning nella fase di allenamento della rete neurale. Crediamo infatti che uno spazio di embeddings ben definito sia di cruciale importanza per la risoluzione del problema di splicing, sia in termini di rilevamento che in termini di localizzazione. Per validare il nostro metodo abbiamo creato due dataset di grandi dimensioni contenenti audio non-spliced e audio spliced, andando a considerare anche audio contenenti più di una singola sezione modificata. Tutti i vocali generati sinteticamente ed utilizzati per la creazione degli audio nei due dataset sono prodotti utilizzando sistemi di sintesi vocale all’avanguardia. Il metodo proposto è stato validato sia sul problema di rilevamento che di localizzazione dei punti di splicing. L’uso di metric learning mostra risultati molto promettenti nel campo del rilevamento e della localizzazione dello splicing, suggerendo alcuni sviluppi futuri in questa direzione. Abbiamo inoltre analizzato l’importanza dell’utilizzo di una funzione di novelty e il suo contributo nel rilevamento e nelle prestazioni complessive della localizzazione dei punti di splicing.

COLZANI LAURA

Titolo tesi: Speech Fingerprinting and Matching for Content Retrieval

Abstract

La tecnologia di audio fingerprinting e matching è ampiamente utilizzata in molti contesti. I suoi vantaggi sono riconosciuti: dalla ricerca alle applicazioni commerciali, dall’ambito forense a, più in generale, tutte le situazioni in cui il recupero di contenuti sonori è vitale. La robustezza di un audio matching condotto sfruttando delle fingerprints è così elevata che può essere efficace anche in ambienti molto rumorosi. In ambito musicale, quasi ogni ipotesi è stata esplorata. Ci si chiede dunque: cosa potrebbe essere possibile se riuscissimo a trovare una metodologia per implementare l’audio fingerprinting per il parlato? Come per la musica, anche uno speech matching potrebbe essere determinante in diversi scenari: dal contrastare la disinformazione individuando i mashup, al monitoraggio dei contenuti virali, e altro ancora. Con questa premessa, l’obiettivo di questo lavoro è quello di studiare, ed ad ultimo fornire, un metodo per il matching e il riconoscimento del parlato utilizzando una fingerprint. Le tecnologie studiate e proposte mirano ad essere efficaci in diversi contesti, come ambienti rumorosi o situazioni in cui si può sentire anche della musica di sottofondo. Dopo un’adeguata spiegazione dello stato dell’arte, proporremo diversi metodi per approcciare il problema: due ispirati direttamente dallo stato dell’arte e basati principalmente sull’elaborazione digitale del segnale, e ulteriori due atti a studiare come i recenti progressi in ambito di deep learning possano aiutare a sviluppare tecniche efficienti per l’estrazione della fingerprint.

Di MARZO FEDERICO

Titolo tesi: Real-time speech dereverberation using a small-footprint convolutional neural network

Abstract

Una sfida che nasce dalla crescente integrazione di dispositivi attrezzati con una Vocal User Interface (VUI), è il miglioramento dell’esperienza dell’utente nel contesto dell’interazione a lunga distanza, chiamata anche interazione in far-field. In questo scenario, l’influenza del riverbero presenta numerosi problemi tecnici. La qualità audio registrata in far-field dai dispositivi dotati di VUI è degradata dagli echi dovuti al riverbero e di conseguenza, sia la comunicazione tra indivudui, sia l’interazioni con sistemi di Automatic Speech Recognition (ASR), presentano un’esperienza utente peggiorata. La presenza del riverbero rende il parlato meno intelligibile durante le chiamate audio, diminuendo la qualità della comunicazione. Esistono diverse tecniche di riduzione del rivebero che mirano a migliorare la qualità audio. In passato, queste tecniche hanno fatto uso di numerose strategie legate all’elaborazione dei segnali o basate sul Deep Learning (DL). Sebbene normalmente molto efficaci, le tecniche di DL sono molto costose dal punto di vista computazionale e della memoria. In questo lavoro di tesi, proponiamo una nuova tecnica, basata sull’utilizzo di un Convolutional Neural Network (CNN), progettato per offrire un basso impatto in memoria e prestazioni ottimizzate, adatta a sistemi che operano in tempo reale, con latenze minime. Utilizziamo il nostro metodo in due modi diversi: sia come un estimatore da integrare con un algoritmo chiamato Weighted Prediction Error (WPE), che in maniera indipendente, come un filtro per la dereverberazione. Dimostriamo come la nostra soluzione consente, attraverso una strategia ibrida di processamento di segnali e DL, di migliorare le prestazioni dell’algoritmo di WPE. Testiamo la nostra soluzione sia per applicazioni legate a VUI, sia per quelle legate alla qualità della comunicazione audio, mostrando come entrambe le versioni della nostra soluzione, superano le prestazioni di altri algoritmi dello stato dell’arte, che operano in tempo reale.

KOUTSOUKOS FOTIOS

Titolo tesi: On the Impact of Foreground and Background Sounds on the Decision-Making Process of CNN-based Acoustic Scene Classification Models

Abstract

Sebbene le reti neurali convoluzionali siano indiscutibilmente diventate lo strumento d’elezione per la classificazione automatica di scene acustiche, la comprensione del loro funzionamento interno resta un interrogativo aperto. In letteratura si possono trovare diverse osservazioni qualitative di come il processo decisionale di tali modelli si basi principalmente sulle componenti tessiturali di una scena acustica piuttosto che sugli eventi acustici che contraddistinguono una registrazione ambientale. In questo manoscritto presentiamo un nuovo metodo per valutare sistematicamente l’influenza che gli eventi acustici in primo piano e il tappeto sonoro sullo sfondo hanno sul riconoscimento di scene acustiche. Il metodo proposto, basato su un’architettura chiamata Mixture of Experts, permette di verificare quantitativamente le precedenti osservazioni qualitative e al contempo individuare quali ambienti sono maggiormente caratterizzati da eventi sonori. Per estrarre le componenti tessiturali e quelle in primo piano, valutiamo diversi algoritmi di decomposizione matriciale allo stato dell’arte applicati a rappresentazioni in tempo-frequenza di scene acustiche. Inoltre, presentiamo un innovativo metodo adattivo basato sulla stima dinamica della probabilità di osservare un evento acustico ad un determinato istante di tempo. Una campagna sperimentale condotta su scene acustiche sintetiche dimostra come il metodo di decomposizione proposto sia superiore rispetto a metodi esistenti.

LAMPIS ALESSIO

Titolo tesi: Experimental Validation for Data Driven Near-Field Acoustic Holography

Abstract

Tra i metodi per la localizzazione di sorgenti sonore utilizzati nel controllo del rumore e nello studio della radiazione acustica, la Near-Field Acoustic Holography (NAH) ha dimostrato di essere uno strumento efficace per l’analisi dell’intero campo acustico irradiato da una sorgente sonora. Comunemente la NAH viene impiegata per la ricostruzione del campo di velocità della sorgente dalla pressione misurata su un ologramma, cioè una superficie posizionata vicino alla sorgente stessa. Recentemente sono state impiegate tecnologie di Deep Learning nell’ambito della NAH. Nello specifico, reti neurali convoluzionali (CNN) sono state usate come approccio innovativo alla NAH per migliorare le performance rispetto ai metodi della letteratura scientifica. Tuttavia, tale approccio con le reti neurali non è stato validato sperimentalmente. Lo scopo di questo progetto di tesi è pertanto quello di validare tali metodologie anche sul piano sperimentale. Per tale scopo, è stato progettato e realizzato un apparato sperimentale atto ad effettuare misure del campo acustico nel near-field irradiato da una tavola di violino. La scelta di questa sorgente sonora è motivata dal fatto che si tratta di un oggetto dalla forma complessa e non convenzionale, che può efficacemente rappresentare un caso realistico. Con il campo di pressione si è potuto predire la velocità del piatto di violino, grazie all’uso delle reti neurali. La validazione della metodologia consiste nel confronto tra la predizione e le misure reali della velocità. Da questo confronto abbiamo concluso che le reti sono parzialmente in grado di stimare il campo di velocità di un piatto di violino. I risultati ottenuti mostrano una differenza in termini di accuratezza della predizione e robustezza al rumore per due reti neurali. Con questo detto, l’approccio data-driven è basato su dati simulati. Per tale motivo, per migliorare le prestazioni delle reti neurali, crediamo che i dati sperimentali che abbiamo raccolto debbano essere presi in considerazione negli sviluppi futuri.

MARELLI GABRIELE

Titolo tesi: Metamaterials in instruments making: cajon peruano case study

Abstract

Da sempre il legno è il principale materiale utilizzato nella costruzione degli strumenti musicali. La sorgente sonora di uno strumento proviene dalle vibrazioni collettive delle parti lignee che lo compongono e che ne definiscono la struttura. Perciò, le scelte prese durante la prima fase di design e di successiva costruzione definiscono il timbro sonoro dello strumento, rendendo così necessario aver ben chiaro il ruolo che ciascuna di queste scelte implica. Ciò non di meno ogni singolo strumento possiede un suono unico anche se è composto dello stesso legno, con la stessa geometria e con gli stessi parametri di un altro strumento. Questo è dovuto a piccole variazioni che sono intrinseche del legno stesso, creando così un problema di coerenza nella costruzione di strumenti musicali. In questa tesi esploriamo la possibilità di utilizzare i metamateriali meccanici per la costruzione, attraverso un modello 3D, della tavola armonica di un cajón peruviano per cercare di regolare i suoi parametri meccanici e la sua risposta vibratoria. Mediante simulazioni di analisi modale ad elementi finiti, col fine di ottenere i suoi modi di vibrazione e frequenze naturali, viene studiato ed analizzato l’effetto che produce una matrice di fori ellittici all’interno di una tavola rettangolare di compensato, ovvero la tavola armonica del cajón. Tramite i valori ottenuti da tali simulazioni, vengono prima derivati i nuovi parametri meccanici delle tavole con i metamateriali e successivamente viene analizzata la risposta acustica in frequenza quando tali tavole vengono applicate al corpo dello strumento. Il cajón è studiato, tramite il metodo ad elementi finiti (FEM), all’interno di un dominio sferico di aria rappresentante lo spazio in cui il suono generato è libero di diffondersi. Osserviamo come differenti disposizioni e dimensioni dei pattern di fori possono modificare i parametri meccanici della tavola armonica rendendo così possibile alterare e regolare, all’interno di un certo range, la risposta vibratoria e acustica dello strumento musicale. I risultati ottenuti in questo lavoro possono essere una solida base per una futura esplorazione della manipolazione del suono attraverso l’utilizzo di metamateriali nella costruzione di strumenti musicali.

MARIANI SIMONE

Titolo tesi: A CNN-based detector for video frame-rate interpolation

Abstract

Al giorno d’oggi, grazie alla diffusione di dispositivi di acquisizione video a portata di mano e all’uso molto diffuso di social network e app di messaggistica, i video vengono condivisi facilmente e sono diventati parte della nostra vita quotidiana. Tuttavia, la manipolazione dei video è diventata alla portata di tutti grazie alla grande disponibilità di software, semplici da utilizzare, per la modifica video. Ciò ha sollevato nuove preoccupazioni sociali, poiché la distribuzione di video manipolati in modo dannoso può portare a gravi conseguenze (ad esempio, diffamazione delle persone, diffusione di notizie false, formazione di opinioni di massa, ecc.). Per questo motivo, la comunità di forensica multimediale ha iniziato a sviluppare una serie di tecniche per stabilire l’autenticità e l’integrità dei video. L’obiettivo di questa tesi è di arricchire il panorama delle tecniche di forensica video, proponendo un detector per identificare l’interpolazione frame-rate di video. Dato un video da analizzare, il nostro obiettivo è di identificare se il video ha subito qualche operazione di sovra campionamento frame-rate che sono solitamente applicate quando molteplici video vengono uniti, o per nascondere alcune parti di un video. La tecnica proposta è basata su un insieme di Convolutional Neural Network (CNN) che lavorano su tre diversi domini video (ovvero, pixels, optical flow e residui di frame), e su una Support Vector Machine (SVM) per una classificazione finale. I risultati mostrano che il metodo proposto supera in prestazioni i più recenti detector di interpolazione frame rate di video, e può anche essere usato per localizzare le regioni di spazio in cui un video è stato interpolato.

MARSON CECILIA

Titolo tesi: EEG data driven automatic soundtrack composition based on emotion recognition

Abstract

Musica e immagini sono componenti fondamentale per l’impatto emotivo durante la visione di un video. La natura degli elementi che contribuiscono a rendere la musica uno stimolo emotivo non è facilmente identificabile. Questo perché le emozioni sono fortemente soggettive. In questa tesi proponiamo un metodo per comporre musica utilizzando le emozioni come input, andando ad analizzare quali elementi possono contribuire a rendere un pezzo più emotivo. Ci sono alcuni elementi misurabili nell’uomo che possono portare informazioni riguardo al mood in un dato istante, come ad esempio i segnali celebrali. Il nostro lavoro propone quindi un metodo che, a partire da questi segnali, suggerisce l’emozione tramite un algoritmo di Machine Learning. Questa viene poi usata per comporre un brano musicale, che esprima una certa emozione, grazie a un algoritmo di Transformer. Nel sistema useremo anche delle features musicali i cui valori hanno una variazione che è legata alla variazione delle emozioni. I segnali celebrali sono tradotti usando un sistema di EEG su soggetti stimolati da video. La musica generata a partire dai segnali acquisiti è usata come soundtrack per altri video. In questo modo il soggetto diventa il compositore della colonna sonora relativa al video che sta vedendo, tramite le sue onde celebrali. Questo studio si propone di aggiungere elementi di ricerca allo studio delle emozioni nell’esecuzione e nella generazione di brani musicali. Abbiamo scelto di effettuare l’acquisizione dei dati di EEG tramite caschetti Muse, in collaborazione con Fuse*Factory, che ne ha approfondito l’uso durante lo studio per le loro performance artistiche.

MASSI OLIVIERO

Titolo tesi: Wave Digital Filter Modeling of Audio Circuits with Hysteresis Nonlinearities using Neural Networks

Abstract

L’isteresi è un fenomeno non lineare con memoria che caratterizza numerosi sistemi audio, come trasduttori piezoelettrici e trasformatori elettrici, dove la sua dipendenza dalla frequenza risulta essere di particolare interesse. A causa della sua natura complessa, l’isteresi è sempre stata difficile da modellare, soprattutto per quanto riguarda la simulazione circuitale. In questo lavoro di tesi, ci avvaliamo di reti neurali per la modellazione della caratteristica isteretica B-H dei materiali ferromagnetici partendo da dati sperimentali. Proponiamo inoltre una nuova modifica al paradigma di addestramento delle reti neurali ricorrenti che ci consenta di riutilizzare le architetture dello stato dell’arte nel contesto della simulazione a tempo discreto. La nuova metodologia proposta è quindi utilizzata per la modellazione nel dominio d’onda dell’isteresi per mezzo dell’integrazione di una rete neurale ricorrente all’interno di un singolo componente circuitale. Il modello sviluppato è infine testato con successo per l’emulazione dello stadio di uscita di un amplificatore valvolare per chitarra.

MIOTELLO FEDERICO

Titolo tesi: A Deep Prior Approach to Inpainting of Audio Signals

Abstract

La perdita o corruzione dell’informazione è un problema ricorrente in nel contesto dei segnali audio. Alcune cause comuni possono essere legate, per esempio, a problemi durante la registrazione, perdita di pacchetti durante la trasmissione o supporti di archiviazione danneggiati. La ricostruzione di campioni mancanti o corrotti in un segnale audio viene chiamata audio inpainting. L’obiettivo dell’audio inpainting è quello di fornire una ricostruzione del segnale mancante che sia pertinente, coerente e perfettamente integrata con le parti del segnale non corrotte e che non introduca artefatti percettibili. Tecniche basate sulla modellazione ed elaborazione dei segnali hanno dimostrato di essere in grado di ricostruire fino a diverse decine di millisecondi di informazione mancante. Ciò nonostante, se si considerano buchi più significativi, le prestazioni di questi metodi calano considerevolmente. Approcci più recenti cercano di superare questi limiti utilizzando tecniche di deep learning. Generalmente, le eccellenti prestazioni di questi modelli, sono da imputare alla loro abilità nell’imparare una generalizzazione da grandi quantità di dati e lunghe fasi di allenamento. Tuttavia, in letteratura è stato dimostrato che la struttura di una rete neurale è sufficiente a permettere di apprendere statistiche a basso livello dei dati considerati, senza ricorrere a fasi di addestramento sui dati. Questo approccio, chiamato deep prior, è particolarmente efficace nel risolvere problemi inversi come l’audio inpainting. In particolare, una rete neurale che utilizza il paradigma deep prior per ricostruire un segnale audio corrotto non necessita di essere allenata con grandi quantità di dati. Al contrario, sfrutta unicamente l’audio danneggiato e, tramite l’analisi delle sue parti non corrotte, è in grado di ricavare i parametri necessari a ricostruirlo. In questa tesi presentiamo un metodo di audio inpainting che utilizza l’approccio deep prior per ricostruire segnali audio che presentino molteplici parti mancanti, ognuna con lunghezza compresa tra 40 ms e 80 ms. L’informazione mancante totale può essere nell’ordine delle centinaia di millisecondi o anche secondi. Il nostro metodo viene validato attraverso un confronto con altre due tecniche di audio inpainting, la prima basata sull’analisi della similarità tra le diverse parti di un segnale, l’altra su un approccio deep learning che, come deep prior, non necessita di una fase di addestramento su un data set esteso, ma solamente sul singolo segnale da ricostruire. I risultati calcolati mostrano che, nel suo dominio di applicazione, la nostra soluzione supera le prestazioni degli altri metodi considerati.

PAPAGNO MIRIAM

Titolo tesi: A Perceptual Evaluation of Sound Field Reconstruction Algorithms

Abstract

Le applicazioni di realtà virtuale e aumentata necessitano di audio spaziale per aumentare il coinvolgimento degli utenti in un ambiente simulato. Le tecniche di ricostruzione del campo sonoro sono impiegate per simulare l’audio in uno spazio chiuso, le cui prestazioni devono essere valutate. Questa tesi mira a valutare quale metodo di ricostruzione di un campo sonoro sia il più adatto da impiegare in tecnologie che emulano la realtà, cioè ambienti 3D virtuali. Fino ad ora queste tecniche sono state valutate per mezzo di metriche oggettive. In questo elaborato vogliamo sottoporre queste tecniche ad un’analisi percettiva, in grado di fornire informazioni sulle prestazioni del metodo impiegato da misure soggettive. L’analisi percettiva si concentra sulla qualità del campo sonoro ricostruito e sull’immersività che offre all’utente, in relazione all’ambiente in cui naviga. All’utente vengono presentati diversi scenari in cui variano le caratteristiche dell’ambiente simulato e, di conseguenza, varia il campo sonoro generato in relazione agli elementi che compongono la scena sonora. La valutazione del segnale ricostruito con i metodi esposti in questo elaborato avviene per mezzo di misure oggettive e soggettive. Queste valutazioni vengono successivamente confrontate per verificare se vi è compatibilità tra i risultati e determinare l’accuratezza di ciascun metodo di ricostruzione. L’analisi oggettiva si concentra sulla distanza tra il segnale ricostruito lungo un percorso definito con microfoni virtuali ed il segnale che verrebbe effettivamente acquisito da microfoni fisici nelle stesse posizioni. Per quanto riguarda l’analisi soggettiva, viene realizzato un test di ascolto per la valutazione percettiva del campo sonoro. I test di ascolto impiegati si basano sul MUSHRA test per attuare un confronto diretto tra i diversi metodi di ricostruzione. Il sistema di riproduzione usato nel test permette di avere un riferimento visivo per individuare la posizione dell’ascoltatore nella stanza, e dunque la posizione del segnale generato nei vari istanti di tempo (l’ascoltatore si muove lungo il percorso predefinito per tutta la durata del segnale). I risultati ottenuti dal confronto tra analisi oggettiva e soggettiva al variare di diversi scenari dimostrano che, a prescindere dalle caratteristiche dell’ambiente, alcune tecniche di ricostruzione dell’audio spaziale sono in grado di simulare l’immersività dell’ascoltatore nell’ambiente virtuale con più precisione rispetto ad altre.

PULVIRENTI CARLO

Titolo tesi: Playlist Generation for Music Exploration Shared between Users Using Conditional Similarity Networks

Abstract

Oggi il modo di ascoltare la musica è drasticamente cambiato rispetto al passato. Con l’avvento di Internet e dei servizi di streaming musicale ciascun utente ha la possibilità di accedere a enormi librerie musicali. Questo nuovo scenario ha reso necessario lo sviluppo di sistemi di raccomandazione musicale, sistemi che guidano l’esplorazione musicale degli utenti in base ai loro gusti musicali e alle loro abitudini. Con esplorazione musicale intendiamo una vera e propria scoperta di nuovi contenuti, che non appartengano necessariamente ai gusti musicali dell’utente. Servizi di streaming, come per esempio Spotify, tendono a proporre brani strettamente collegati all’utente e con maggiore popolarità, cosa non sempre desiderata. Molti utenti infatti non comprendono pienamente la logica dietro una determinata raccomandazione, preferendo invece ricevere consigli dai propri amici. Infatti generalmente sono disposti ad ascoltare canzoni anche lontane dai propri gusti musicali se vengono consigliate da un amico, creando un esperienza condivisa con quest’ultimo. Partendo da queste considerazioni, in questa tesi proponiamo un metodo per la creazione di playlist esplorative con l’obiettivo di tracciare un percorso musicale tra due persone, e quindi tra i loro gusti musicali. Per realizzarlo, ogni canzone viene rappresentata come un punto in uno spazio musicale multidimensionale di similarità, implementato tramite una Conditional Similarity Network. Il profilo musicale di ciascun utente viene definito analizzando la cronologia di ascolto. Infine vengono calcolati i punti nello spazio che rappresentano le canzoni finali che faranno parte delle playlist. Ogni utente ha la possibilità di scegliere l’amico verso cui dirigere l’esplorazione ed eventualmente anche una dimensione di similarità tra genre, mood, instrument ed era sulla quale sarà definito lo spazio musicale di partenza. Per valutare il metodo abbiamo eseguito tre diversi esperimenti. Nel primo esperimento analizziamo il training della rete e valutiamo la qualità dello spazio creato. Il training è stato eseguito utilizzando tecniche di estrazione di terzine offline e online. Un secondo esperimento è stato effettuato per valutare l’algoritmo di generazione delle playlist usando un dataset pubblico, Last.fm dataset 1k. Per valutare la fluidità delle transizioni tra le canzoni sono stati analizzati gli andamenti sulla presenza dei tag lungo le playlist. Nell’ultimo esperimento valutiamo l’esperienza utente complessiva, usando le cronologie musicali dei partecipanti per generare playlist personalizzate. Le valutazioni sono state ottenute tramite la compilazione di due sondaggi riguardanti il gradimento, l’esplorazione e la percezione del percorso musicale verso l’amico selezionato. I risultati del primo esperimento ci hanno mostrato che la strategia migliore è utilizzare una combinazione di due training, cioè partendo con la creazione offline di triplette e proseguendo con una tecnica di calcolo di triplette online, chiamata batch semi-hard. I risultati del secondo esperimento hanno confermato che l’andamento della presenza dei tag è decrescente rispetto ai tag contenuti nella prima canzone e crescente rispetto a quelli dell’ultima canzone. Questo significa che il sistema di generazione della playlist è in grado di realizzare un percorso graduale tra il punto di partenza e quello di arrivo. La valutazione dell’ultimo esperimento conferma invece che il grado di esplorazione è molto alto e, nonostante questo, il gradimento in media è buono. Le valutazioni dell’esperienza complessiva sono molto positive: in particolar modo le persone hanno trovato molto interessante la possibilità di scegliere un amico per guidare l’esperienza di esplorazione musicale. Lavori futuri potrebbero riguardare l’utilizzo di altre dimensioni di similarità musicale e prevedere un’interfaccia utente a supporto del metodo, creando quindi un’esperienza utente completa. Inoltre potrebbe essere interessante estendere questo metodo per creare playlist a partire dai gusti di un gruppo di utenti.

SCHGOR MARTINO

Titolo tesi: Compensation of phase distortion in high-performance audio systems

Abstract

I costruttori di dispositivi Hi-Fi usano spesso delle misure quantitative quali la risposta in frequenza, distorsione armonica o potenza massima, come indici di qualità dei propri prodotti. Queste caratteristiche vengono ottimizzate con cura estrema, e riportate orgogliosamente nelle pubblicità per vantare la miglior fedeltà di riproduzione possibile. La risposta in fase dei sistemi (ovvero la distribuzione dei ritardi a cui è soggetta ciascuna componente spettrale) è pressoché ignorata, poiché molti ritengono che non abbia alcun effetto sull’esperienza di ascolto. Tuttavia, la letteratura scientifica degli ultimi decenni documenta diversi fenomeni di udibilità della distorsione di fase, ossia il cambio nella forma d’onda di un segnale dovuto a una risposta in fase non ideale. Le sue conseguenze sull’ascolto sono marginali, eppure non possono essere ignorate in un ambito dove l’ottimizzazione della fedeltà è portata agli estremi. La presente tesi si propone come un’analisi delle origini della distorsione di fase in sistemi di riproduzione audio, nonché dei suoi effetti percettivi. Inoltre, riportiamo degli esperimenti che sono stati eseguiti nel tentativo di correggere la distorsione di fase per una migliore fedeltà di riproduzione audio, usando del processamento di segnali digitali in tempo reale.

SORINI LUCA

Titolo tesi: Studio numerico del modello aeroacustico di una canna d’organo labiale aperta

Abstract

I meccanismi che consentono alle canne d’organo la creazione di un suono stazionario sono stati indagati e vengono tutt’ora analizzati da tanti scienziati, affascinati dalla particolarità dei fenomeni fisici che si verificano in così poco spazio e che i costruttori d’organo sembrano manovrare alla perfezione da secoli per la creazione di timbri unici e divini. Il fenomeno acustico della generazione del suono in una canna d’organo è strettamente accoppiato con la complessa dinamica del flusso d’aria che entra nella canna stessa, tuttavia la sua descrizione è tutt’altro che semplice in quanto nella zona della bocca della canna d’organo si verificano dei fenomeni di turbolenza che ancora oggi faticano ad essere pienamente compresi e che hanno un’influenza non ancora del tutto chiara sul suono emesso dalla canna. Lo scopo di questo lavoro è stato di utilizzare il metodo degli elementi finiti per modellare i fenomeni aeroacustici in una canna d’organo labiale aperta a sezione rettangolare, tipica del registro di Flauto col fine di gettare le basi per studi più dettagliati volti ad analizzare come l’influenza dei vari parametri geometrici della canna e del flusso d’aria entrante o delle loro possibili combinazioni possano influenzare le caratteristiche del suono emesso. La modellazione geometrica e le analisi numeriche sono state svolte con il software COMSOL Multiphysics. Il problema è stato studiato dal punto di vista fluidodinamico risolvendo le equazioni di Navier-Stokes per fluidi viscosi e comprimibili che permettessero di tener conto dei fenomeni dissipativi e delle turbolenze generate dal getto d’aria entrante nella canna. Nonostante le limitazioni di un modello bidimensionale, è stato possibile osservare alcuni comportamenti interessanti, in particolar modo in merito alla determinazione della lunghezza acustica della canna che determina la frequenza fondamentale del suono emesso, la quale differisce dalla lunghezza reale della canna in modo differente a seconda non solo della profondità della canna come riportato dagli studi sperimentali dell’organaro francese Cavaillé-Coll, ma anche dagli altri fattori geometrici caratteristici della canna. Questo suggerisce che la lunghezza acustica di una canna aperta possa dipendere da una complessa combinazione di molti parametri, gettando le basi per futuri studi più approfonditi volti alla formulazione di una relazione che possa esser d’aiuto per la ricerca della combinazione ottimale di tutti questi parametri.

ZANETTI GIULIO

Titolo tesi: Few-Shot Anomalous Sound Detection in Domestic Environments Using Large-Scale Pretrained Audio Pattern Recognition Models

Abstract

Le tecniche di rilevamento di suoni anomali basate su apprendimento automatico possono trovare spazio in diversi scenari applicativi, in particolare nel monitoraggio di ambienti domestici. In questi ambienti, le classi di suoni da considerare anomali sono dipendenti dalla situazione e non possono essere conosciute in anticipo. Per questo motivo è spesso necessario ricorrere all’uso di tecniche non supervisionate. I sistemi non supervisionati sono più inclini a rilevare falsi positivi rispetto a quelli supervisionati e, prendendo in considerazione la possibilità di integrare un rilevatore di anomalie nei dispositivi IoT presenti nelle nostre case, l’eventuale eccesso di falsi allarmi diventa una questione prioritaria da affrontare al fine di sviluppare prodotti commercialmente validi. In questa tesi presentiamo un nuovo metodo in grado di aggiornare, con pochi dati a disposizione, la conoscenza di un rilevatore di anomalie non supervisionato. Questo lavoro si concentra sull’uso di un sistema ausiliario a supporto di un modello non supervisionato. In particolare, assumiamo che il sistema proposto possa occasionalmente sottoporre all’utente richieste di conferma riguardo l’esito della sua decisione. La necessità di ridurre al minimo l’interazione con l’utente rende indispensabile lo sviluppo di una tecnica in grado di riconoscere eventi acustici avendo accesso a un numero molto ridotto di esempi. L’architettura proposta per il sistema ausiliario è un modello di riconoscimento di strutture audio addestrato su una grande quantità di dati che ha il ruolo di generare un descrittore numerico per ciascuno degli eventi acustici registrati. Questi descrittori sono poi confrontati con quelli estratti dalla registrazione dell’ambiente domestico, e il grado di similarità così calcolato può dunque essere usato per rendere più robusto il processo di classificazione. Risultati sperimentali ottenuti su dati sintetici che emulano le caratteristiche sonore di un ambiente domestico mostrano che la tecnica proposta apporta un sostanziale miglioramento a un rivelatore non supervisionato, superando metodi esistenti sviluppati per il monitoraggio di macchine industriali.